Wprowadzanie w błąd testów A/B jest proste

autor: Rostyslav Mykhajliw Założyciel TrueSocialMetrics.com ~ 4 min

Klasyczny

Klasyczne testy A/B to dystrybucja między różnymi stanami. Zacznijmy od ogólnej próbki, której wszyscy używają. Mamy stronę z przyciskiem rejestracji, obecnie jest niebieski, ale chcemy przetestować nowy kolor czerwony.

Następnie alokujemy tam trochę ruchu i trochę czekamy. Istnieje prosty kalkulator dla statistical significance.

Wariant A: 50 000 odwiedzających - 500 rejestracji Opcje B: 50 000 odwiedzających - 570 rejestracji - zwycięzca

B jest zwycięzcą, to jasne. Więcej rejestracji, istotność statystyczna.

Nowe klasyczne jabłko do pomarańczy

Poczekaj chwilę! Co wydajemy coś nowego. Na przykład dodajemy przycisk „demo” do przeglądania przewodnika krok po kroku po produkcie.

Jeśli zastosujemy się do prostej logiki testów A/B – to nie zadziała! Ponieważ nie możemy porównywać jabłek z pomarańczami. Nie możemy niczego porównywać do czegoś! To całkowicie niepoprawne. Jeśli nie ma przycisku demo, użytkownicy mogą mieć gorsze wrażenia niż ci, którzy mają tę opcję. Ale ta opcja może pomóc tylko użytkownikom, którzy już są zainteresowani produktem lub niedawno zgłosili się do korzystania z produktu. Nawet jeśli masz miliony ruchu, nie możesz powiedzieć, jak to działa w ciągu kilku godzin/dni, ponieważ wyniki mogą być odłożone w czasie.

Nowa funkcjonalność powinna być uwalniana liniowo, podobnie jak proces uwalniania dojelitowego. Dopiero potem po pewnym czasie możemy na to spojrzeć i dowiedzieć się, czy miało to jakiś wpływ na doświadczenie klienta, czy nie, ale śledzenie wskaźników biznesowych. Testy A/B NIE mają zastosowania do nowej funkcjonalności.

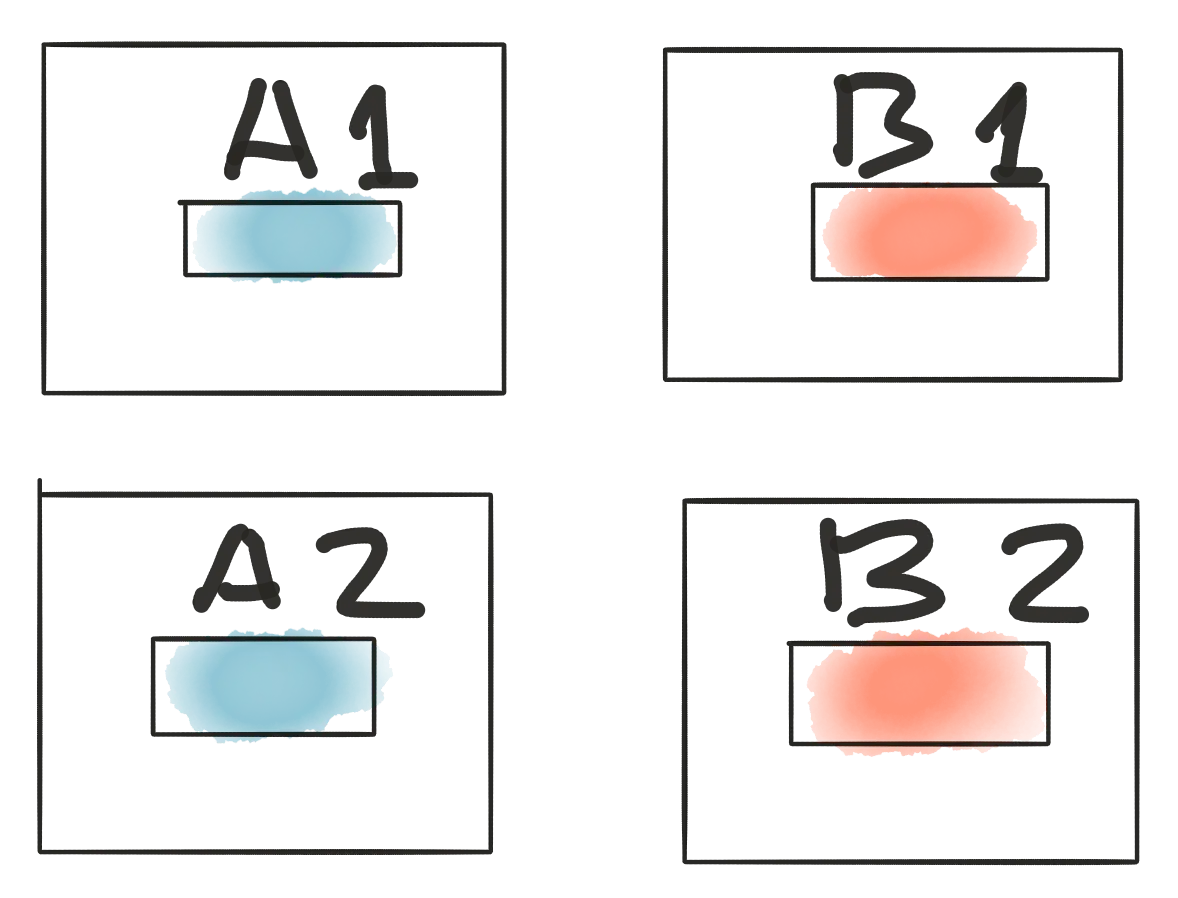

AA/BB testuje pewność siebie

Wróć do pierwszej próbki za pomocą przycisku rejestracji. Jeśli nasze przypuszczenia są poprawne, możemy dodać więcej opcji A i więcej opcji B i nic się nie zmieni, ponieważ B nadal może wygrać bitwę.

Następnie spójrz na wyniki:

A1: 50 000 odwiedzających - 500 rejestracji A2: 50 tys. odwiedzających – 580 rejestracji – zwycięzca B1: 50 tys. odwiedzających – 570 rejestracji – zwycięzca B2: 50 000 odwiedzających - 500 rejestracji

CO! CO! CO! Można powiedzieć, że to niemożliwe, ale ta sytuacja pokazuje różnicę, jeśli alokacja odwiedzających ma wpływ na wyniki testów. Te wyniki pokazują stabilną istotność statystyczną na poziomie 95%, ale niską pewność.

Testy adaptacyjne

Jeśli cofniemy się do początku artykułu zauważymy ogromny ruch 50k odwiedzających i 500 przejść potrzebnych do uzyskania miarodajnych wyników. Jednak nie wszystkie strony mają taką możliwość. Nie wszystkie startupy są wystarczająco dobre, aby generować taki ruch, lub mogą to być strony o niskim ruchu, takie jak ustawienia/rozliczenia itp. We wszystkich tych przypadkach klasyczne testy a/b zajmą ogromną ilość czasu, aby zebrać dane miesiące/pół roku lub tak. Kolejną wadą ogólnego podejścia jest to, że co najmniej 50 tys. odwiedzających (ze 100 tys. przydzielonych do testu) miało gorsze doświadczenia klientów. Czekamy więc długo i tracimy klientów z powodu przydziału do „przegrywającego” testu. Czy to ma jakiś sens ? W służbie zdrowia lekarze przekreślili problematykę przypadków, ale w tabeli było ludzkie życie. Jeśli zrobimy test podczas którego 50% pacjentów umiera z powodu „jeszcze nie przetestowanej opieki”. I to jest zajebiste. Oto facet Marvin Zelen, który wpadł na pomysł testów adaptacyjnych, nazywa się teraz Zelen’s design.

W skrócie

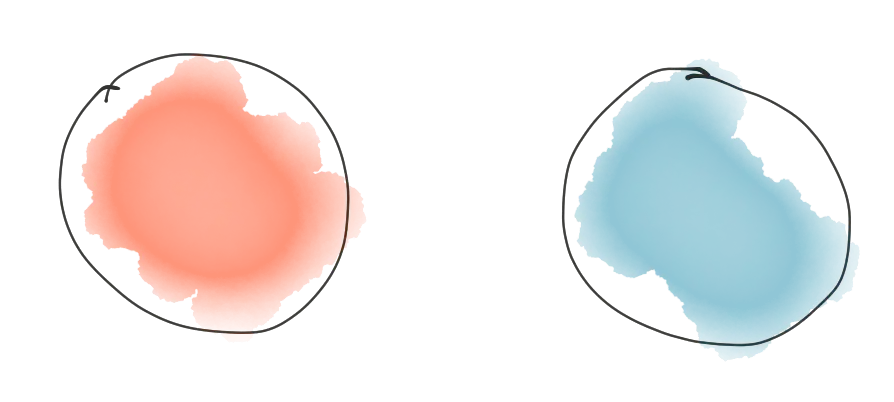

Wyobraźmy sobie, że mamy 2 możliwości: kule czerwoną i niebieską, więc statystycznie jest to 50% prawdopodobieństwo.

Na przykład losowo przydzielamy odwiedzającego do „niebieskiego”, a „niebieski” jest lepszym doświadczeniem, ponieważ dostaliśmy zakup. W tym przypadku „niebieska” wygrywa, dlatego do puli dodajemy dodatkową „niebieską” kulę.

W rezultacie zmieniło się prawdopodobieństwo „czerwonych” - 33% i „niebieskich” - 67%

Brzmi dobrze! Ale następny gość z „niebieskim” nic nie robi. Czyli „niebieska” przegrywa, dlatego musimy usunąć jedną „niebieską” kulę z puli i mamy nasz poprzedni stan.

Plusy: + działa przy małym natężeniu ruchu + adaptacyjnie zapewnia lepszą opiekę użytkownikom Wady: - wymaga, aby programiści pracowali nad ustaleniem wygranych/przegranych testów w trakcie testowania

Wstrząsy mózgu

- Klasyczne testy A/B nie działają w przypadku nowych funkcji, ponieważ nie można niczego testować za pomocą czegoś

- Zwykle testy A/B NIE są reprezentatywne, nawet jeśli Twoje analizy wskazują, że tak jest

- Podejście AA/BB pomaga sprawdzić wyniki testów A/B

- Testy adaptacyjne są bardzo przydatne w przypadku małego ruchu, ale wymagają ręcznej pracy, aby osiągnąć wyznaczone cele

Kiedy będziesz gotowy, by zakołysać swoją analityką w mediach społecznościowych

wypróbuj TrueSocialMetrics!

Rozpocząć proces

Nie wymagamy karty kredytowej.